OpenAI GPT2: quand l’IA sait parler pour ne rien dire

Si vous avez des doutes sur les progrès réalisés en matière d’apprentissage et d’intelligence artificielle, allez donc faire un tour du côté d’OpenAI, un laboratoire de recherche sur l’IA à but non lucratif, co-financé par Elon Musk (SpaceX, Tesla), Reid Hoffmann (LinkedIn), Sam Altman (Y Combinator), Peter Thiel (Paypal), Jessica Livingston et Greg Brockman. Vous y trouverez une littérature abondante (en anglais), ainsi que du code en open source, vous permettant de réaliser des choses étonnantes. Mais si j’en parle aujourd’hui, c’est que ce labo a défrayé la chronique il y a quelques jours, en annonçant qu’il renonçait à distribuer la dernière mouture de son générateur de texte. Intitulée GPT2, elle serait en effet capable de produire … des fake news ayant la qualité d’un texte authentique.

Bien évidemment, une pareille annonce, légèrement racoleuse, ne peut que générer un buzz d’enfer. De nombreux titres de presse ont repris cette annonce, avec à l’appui quelques vidéos qui illustrent le mode de fonctionnement de GPT2. L’exemple ci-après part de la première phrase d’un article du Guardian sur le Brexit, et construit un article, dont la qualité sémantique vaut largement celle d’un papier qu’aurait pu écrire un journaliste de la presse économique. Regardez la vidéo suivante, c’est étonnant.

Comment ces chercheurs ont-ils réussi à produire un tel système? L’article publié sur le blog d’OpenAI l’explique de manière assez abordable. Lorsqu’on conçoit une application basée sur de l’IA, la qualité de l’algorithme est tout aussi importante que la qualité des données qu’on lui fournit, et du type de question qu’on lui pose. Ici, les chercheurs qui ont mis au point GPT2 lui on fait « lire » 40 giga-octets de texte provenant d’Internet, et ne lui ont appris qu’une seule chose: à prévoir quel serait le mot suivant. En termes techniques, il s’agit d’un apprentissage non supervisé, dont la première version a tourné pendant 1 mois sur 8 GPUs.

Cette technique d’apprentissage ressemble comme deux gouttes d’eau à l’apprentissage d’une langue par un être humain. Qu’est ce, en effet, que connaître une langue? C’est reconnaître les structures des phrases et les associations de mots usuelles, de manière à en extraire du sens. Un individu qui parle français, par exemple, acceptera parfaitement que le terme meunière suive le terme sole. Pour un individu parlant anglais, en revanche, cette association est peu probable, alors que celle de sole et initiative lui paraîtra plausible. Apprendre à parler ou lire une langue, c’est principalement (que les profs de langue qui lise cet article me pardonnent) apprendre à reconnaître des enchaînements de termes plausibles.

Et bien c’est exactement ce que fait GPT2. Bon, dans la réalité, c’est un peu plus complexe, et le papier suivant l’explique dans des termes techniques plus précis qui intéresseront les spécialistes. Le résultat est tellement bluffant, que contrairement à leur habitude, les chercheurs qui ont travaillé sur ce logiciel ont décidé de n’en livrer qu’une version bridée – un peu comme si Porsche ne vendait que des voitures limitées à 130km/h (ce qui ne serait pas une mauvaise idée, non?).

Pour justifier leur décision, les auteurs de GPT2 mettent en avant les risques que pose un tel outil. Le pouvoir a toujours appartenu à celles et ceux qui maîtrisaient le langage. Quand rien ne permet de distinguer le vrai du faux, la manipulation peu rapidement devenir un jeu. Avec un outil aussi puissant, pensent-ils, la fabrique des fake news serait à la portée du premier venu. C’est possible, si tant est qu’on peut orienter la génération automatique de tels textes dans un sens ou dans l’autre.

Les chercheurs d’OpenAI ont clairement exprimé leur crainte, de voir de telles approches être développées par des laboratoires aux intentions moins nobles. Tout comme les manipulations génétiques, les travaux menés en intelligence artificielle, sans avoir besoin de simuler l’être humain dans toutes ses capacités, peut poser des problèmes majeurs.

We are aware that some researchers have the technical capacity to reproduce and open source our results. We believe our release strategy limits the initial set of organizations who may choose to do this, and gives the AI community more time to have a discussion about the implications of such systems.

We also think governments should consider expanding or commencing initiatives to more systematically monitor the societal impact and diffusion of AI technologies, and to measure the progression in the capabilities of such systems. If pursued, these efforts could yield a better evidence base for decisions by AI labs and governments regarding publication decisions and AI policy more broadly.

On peut aussi voir les autres possibilités offertes par de tels outils. D’un point de vue créatif, tout d’abord. La bibliothèque de Babel, imaginée par Borges, celle qui contiendrait tous les livres possibles, serait enfin à notre portée: il suffirait de laisser GPT2 tourner en boucle… En intégrant un tel système dans un robot humanoïde, on pourrait proposer aux personnes souffrant de solitude des compagnons capables d’entretenir une conversion sans fin, et parfaitement logique. Les impacts sur les métiers de la communication écrite seraient sans doute non négligeable: en termes de production de contenus pour alimenter un site web, par exemple.

Mais très vite, on touche du doigt à des problèmes majeurs, qui pourraient chambouler le mode de fonctionnement de nos sociétés humaines, qui se sont construites, avant tout, sur la collaboration et le développement d’affects et de synergies, basés sur le langage. L’absence de conscience est encore plus intrigante: voilà un programme capable de s’exprimer correctement dans la langue de Shakespeare, mais qui n’a absolument aucune conscience de ce qu’il dit. C’est comme si un élève exposait la solution d’un problème de maths compliqué, sans avoir besoin de comprendre l’énoncé, ni même le sens de sa solution. Surprenant, non?

Découvrez d'autres articles sur ce thème...

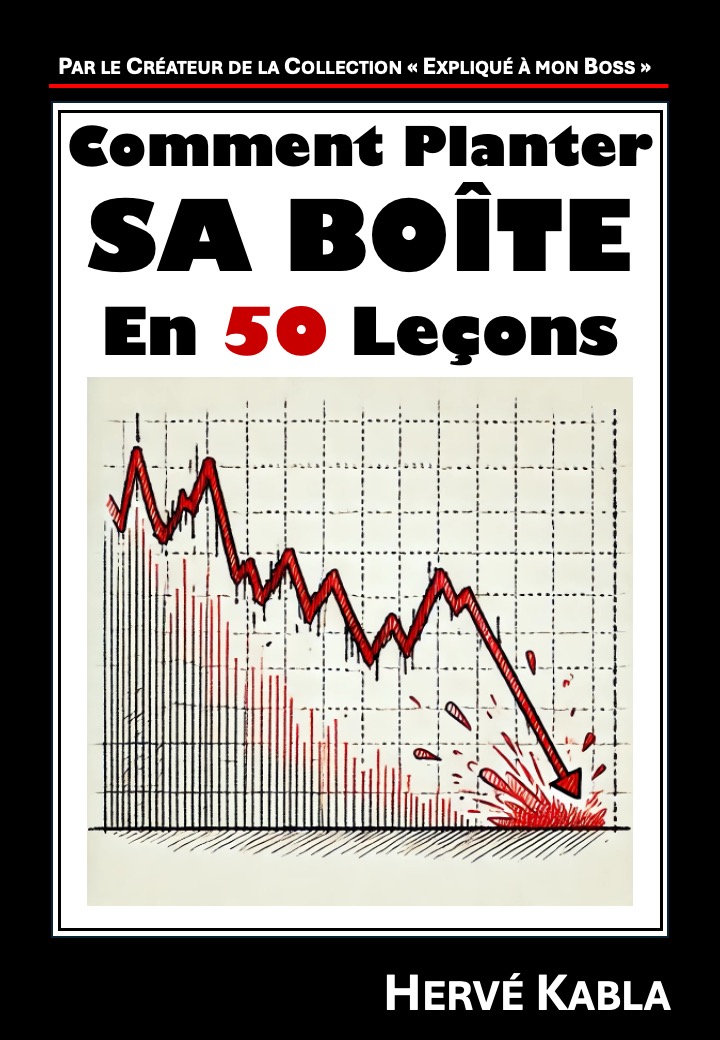

Hervé Kabla, ancien patron d’agence de comm’, consultant très digital et cofondateur de la série des livres expliqués à mon boss.

Crédits photo : Yann Gourvennec